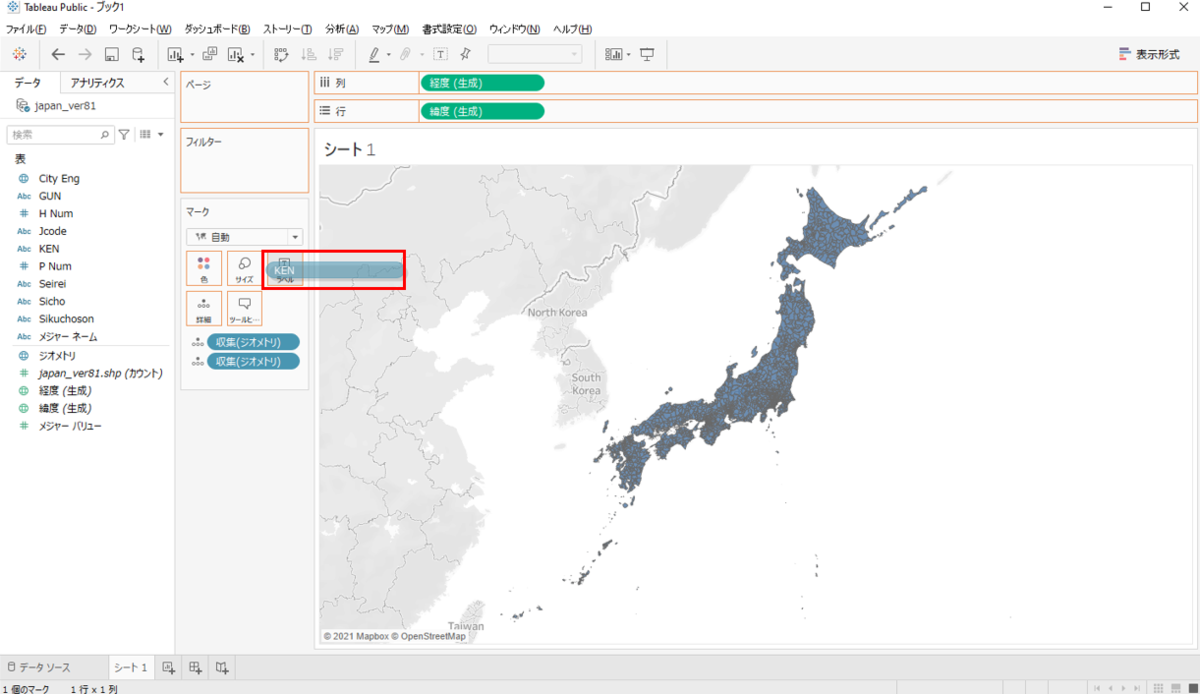

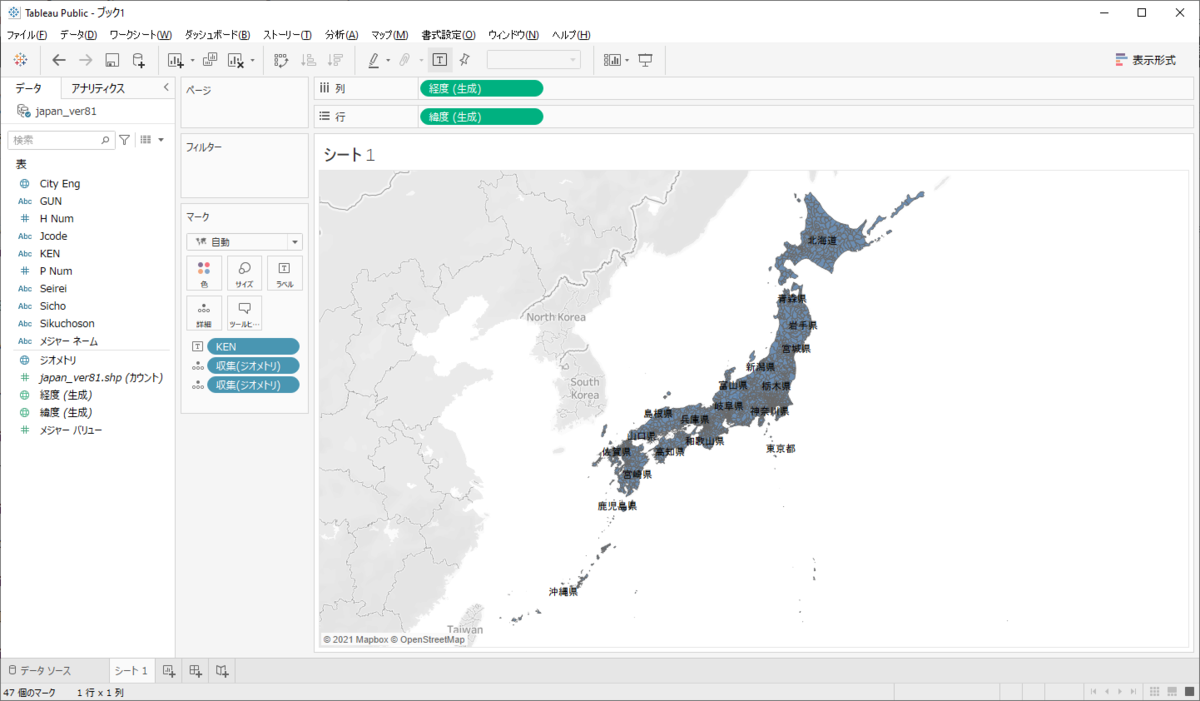

さて、本日も前回のエントリーに続き Tableau について書いてみようと思います。以下のエントリーで Tableau を使って地図データを可視化してみましたが、今回はもう一歩踏み込んで空間関数を使ってみようと思います。

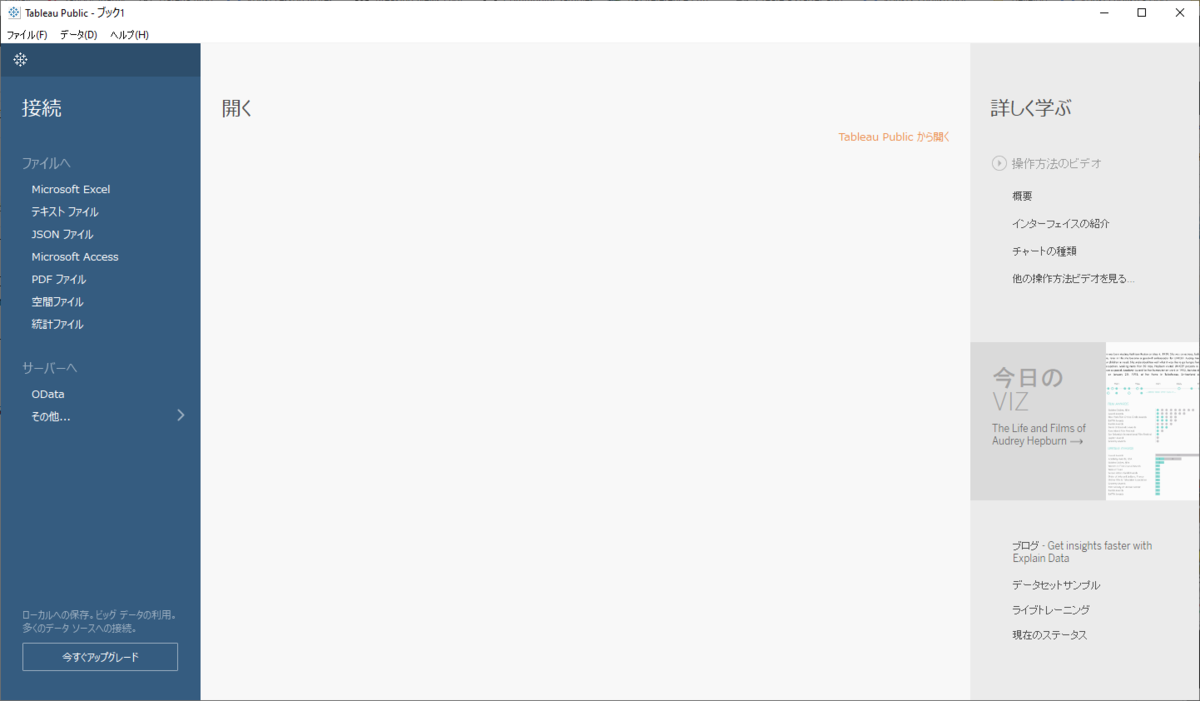

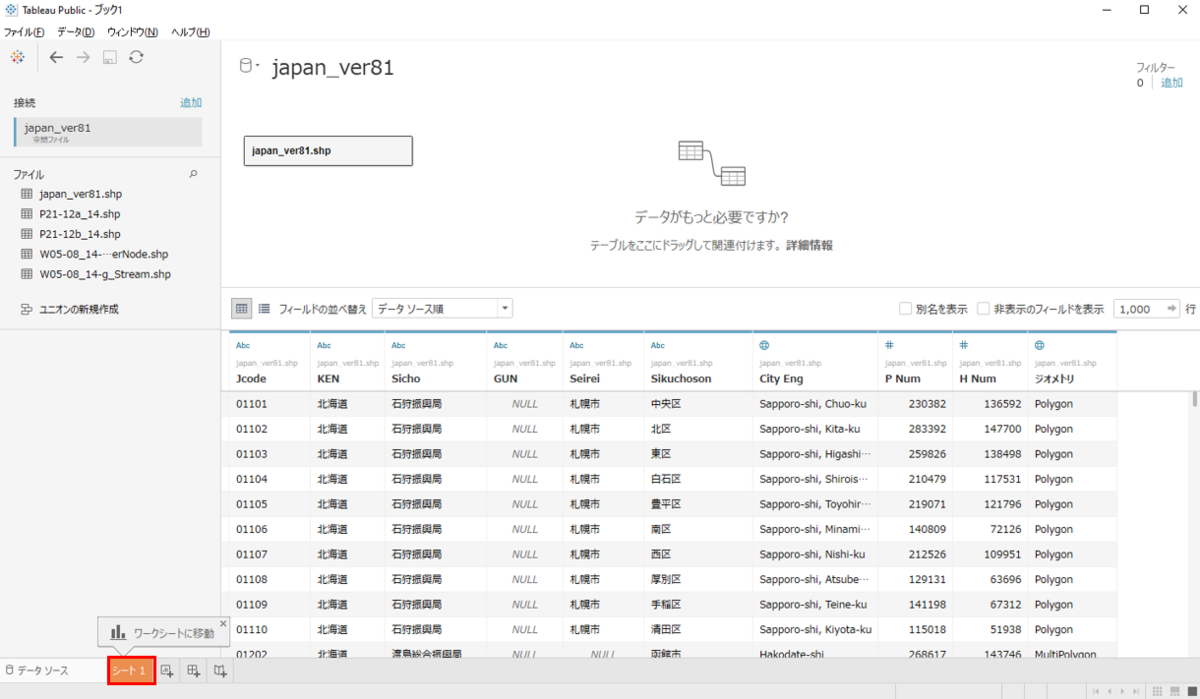

使用するデータ

ESRIジャパンさんが主催した「ArcGIS 開発者のための最新アプリ開発塾 2020」で使用された 各店舗売上.csvを使用します。

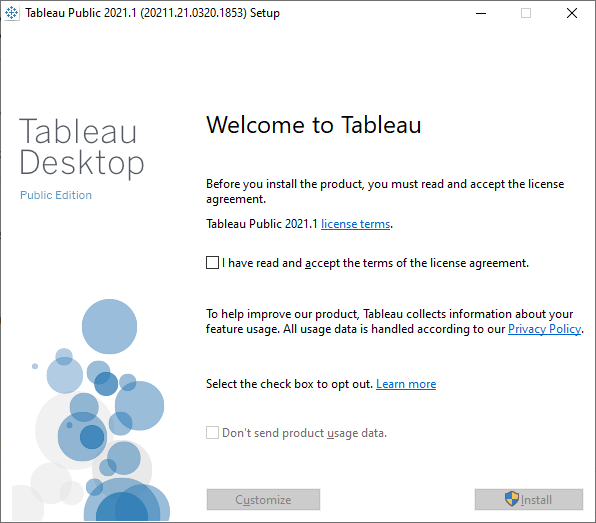

環境

Windows10 64bit

Tableau Desktop Public Edition 2021.1.0 64bit

使用する空間関数

- MakePoint・・・緯度経度からポイントを作成

- MakeLine・・・二つのポイントからラインを作成

- Distance・・・2 つのポイント間の距離を計測

- バッファー・・・ポイントのバッファーを作成

バッファーを作れるなんて素晴らしいですね!そして Tableau 恐るべしです。

MakePoint

緯度経度からポイントを作成します。

1.分析>計算フィールドの作成

2.MAKEPOINT([緯度],[経度]) と入力>OK

左側のデータ欄に「ポイント」が作成されたことがわかります。

3.「ポイント」をダブルクリック ポイントが可視化されました。

MakeLine

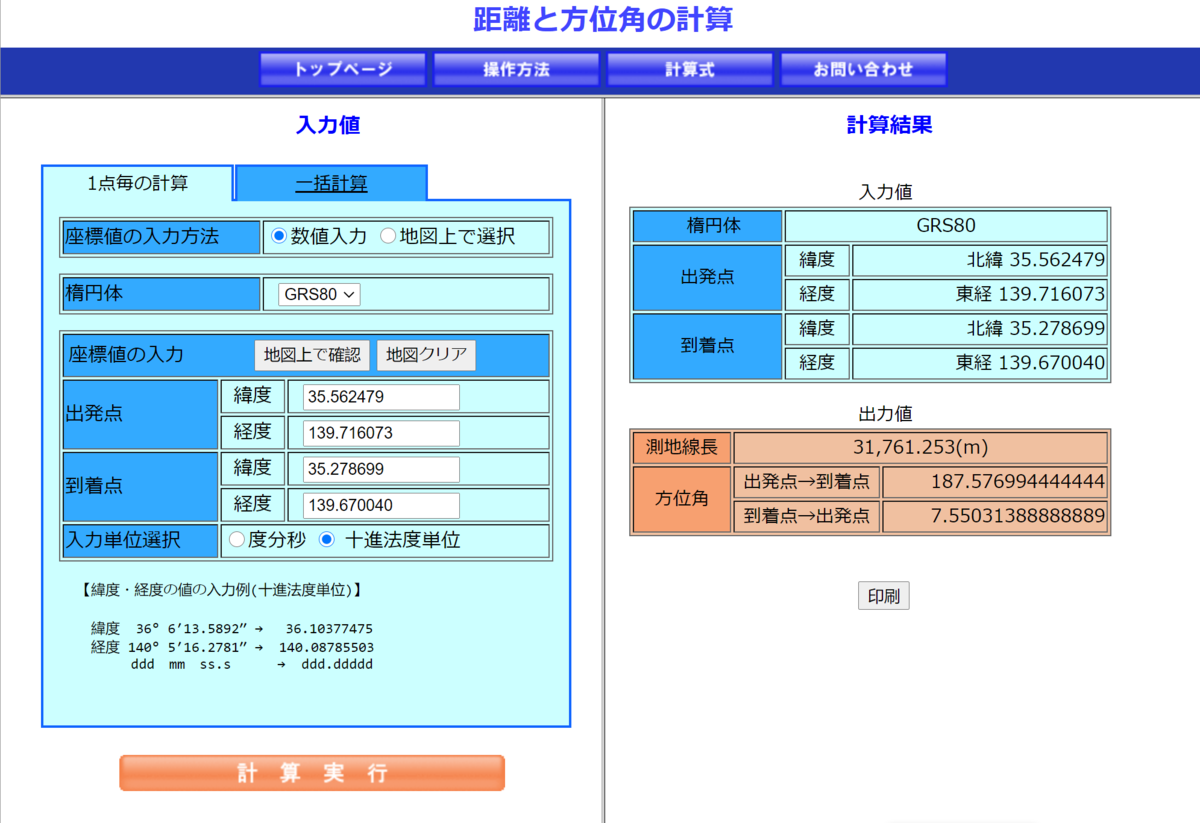

二つのポイントからラインを作成します。ここでは「蒲田駅」から「横須賀中央駅」の距離を計測してみようと思います。それぞれの緯度経度は以下です。

- 蒲田駅

- 緯度 35.562479

- 経度 139.716073

- 横須賀中央駅

- 緯度 35.278699

- 経度 139.670040

1.分析>計算フィールドの作成

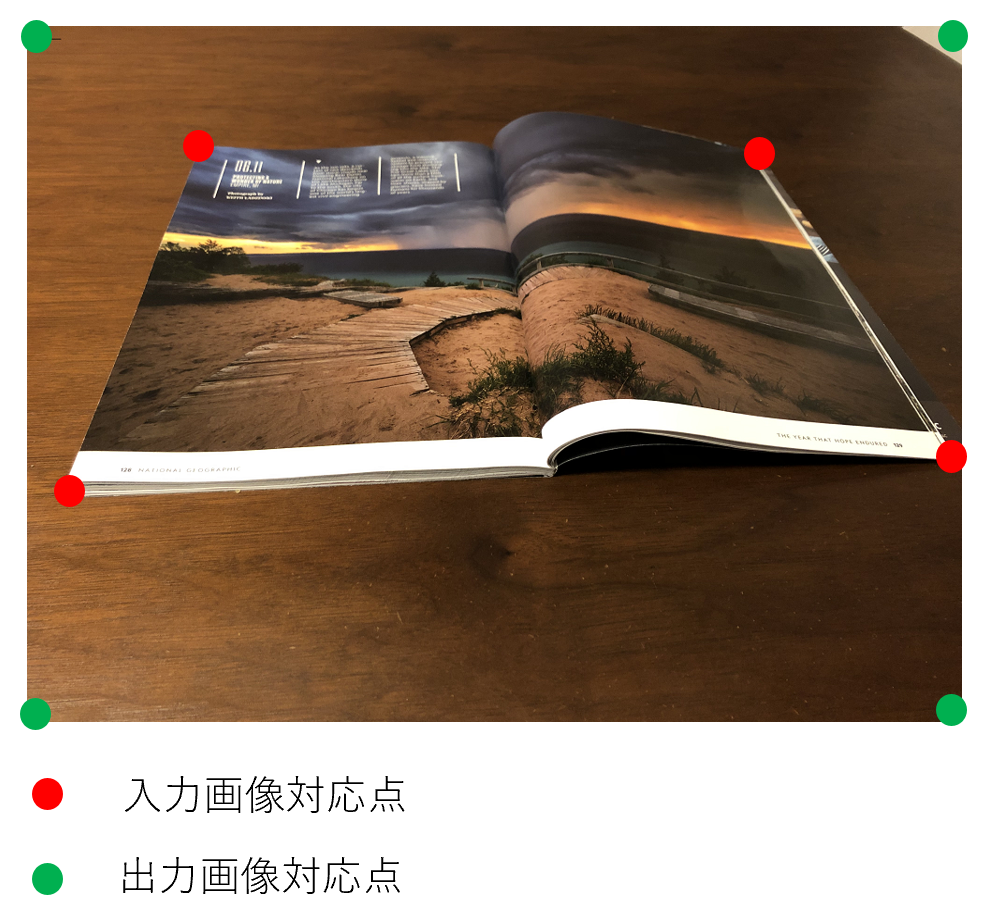

2.MAKELINE(MAKEPOINT(35.562479,139.716073),MAKEPOINT(35.278699,139.670040))>OK

左側のデータ欄に「ライン」が作成されたことがわかります。

3.「ライン」をダブルクリック

蒲田駅~横須賀中央駅間でラインが可視化されました。

拡大してみましたが、駅が確認できません。

しかし、Tableau は以下のような手順で背景図を選ぶことができます。素晴らしいですね。

このように作成したラインが本当に蒲田駅~横須賀中央駅かどうか確認することができました。

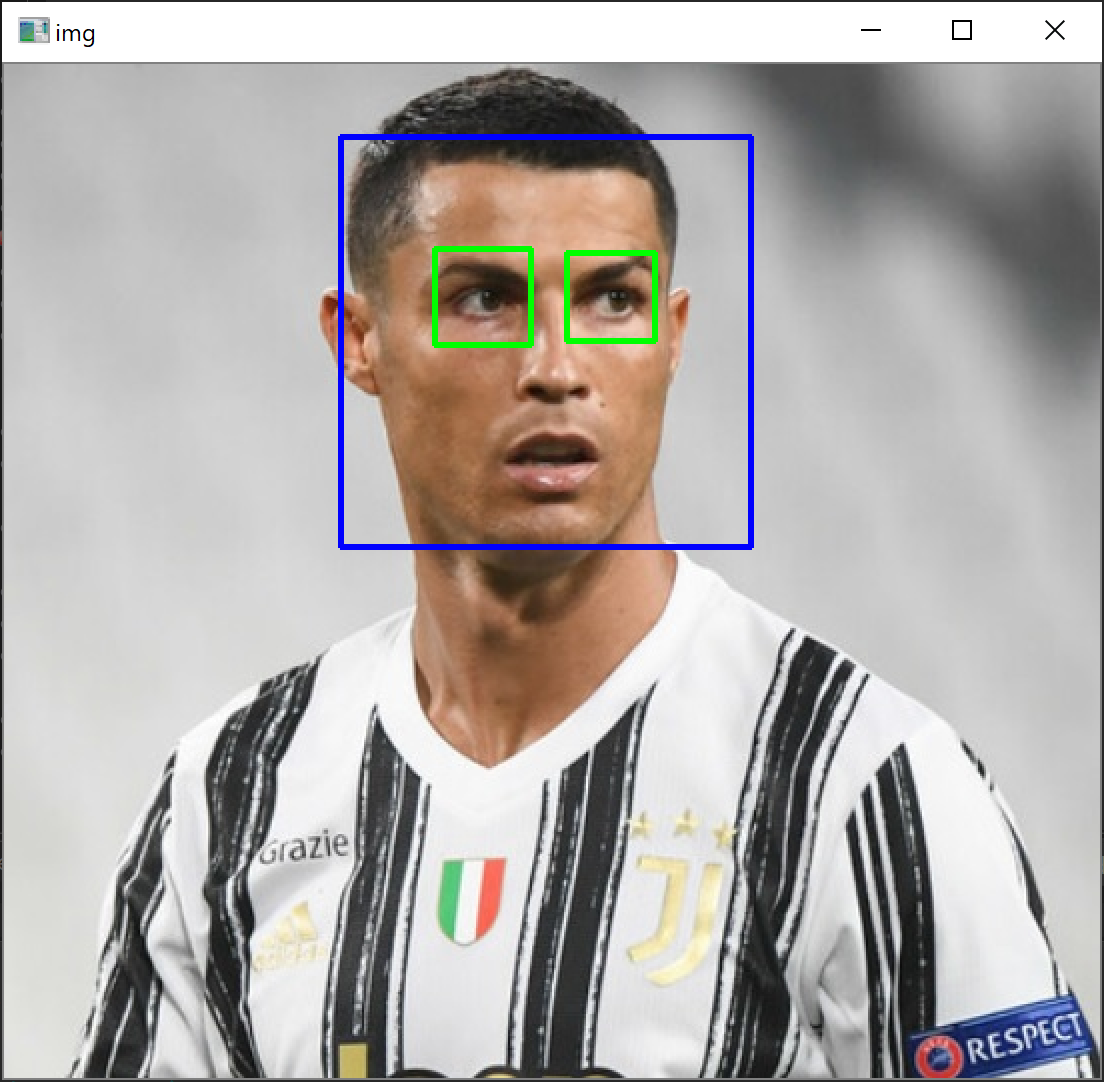

Distance

2点間の距離を測ります。

1.分析>計算フィールドの作成

2.DISTANCE(MAKEPOINT(35.562479,139.716073),MAKEPOINT(35.278699,139.670040),"km")と入力>OK

左側のデータ欄に「距離」が作成されたことがわかります。

3.「距離」を「ラベル」にドラッグアンドドロップします。

4.ラベル>フォント>フォントサイズを24にします。

「距離」が表示されました。しかし、数値がおかしい気がします。蒲田駅~横須賀中央駅間は3049kmもありませんね・・・

5.合計(距離)>メジャー(合計)>平均を押下します。

以下のエントリーと同じく蒲田駅~横須賀中央駅間は31.76kmという結果になりました。

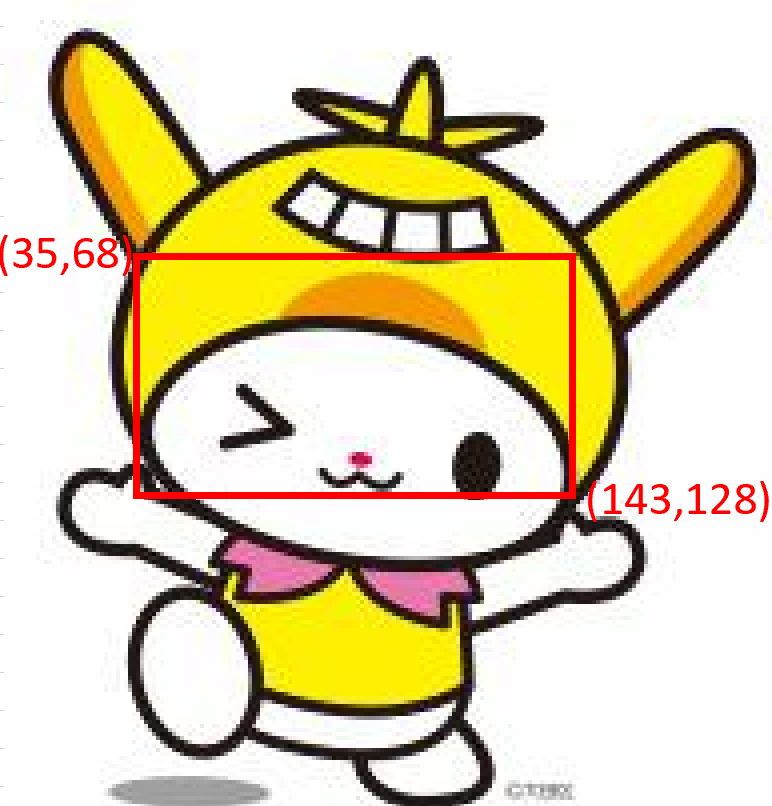

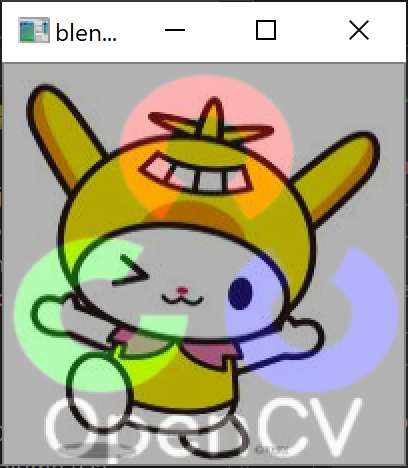

バッファー

ポイントに対して300mのバッファーを作ります。

1.分析>計算フィールドの作成

2.BUFFER([ポイント],300,"m")と入力>OK

左側のデータ欄に「バッファー」が作成されたことがわかります。

3.「バッファー」をダブルクリック

バッファーが作成されたことがわかります。

さいごに

まさか Tableau でバッファーまで作れるとは思ってなかったので、これは意外な発見でした。まだまだ知らない機能がありそうなので、引き続き色々触って勉強してみようと思います。本日は以上です。